Angeregt durch Bernd Reuschenbachs Beitrag über meinen Blog habe auch ich nochmals über meinen Blog nachgedacht. Was 2005 durch eine Alumna (Claudia Frey) angestoßen wurde, hat sich nun beinahe für 20 Jahre (die erreiche ich – hoffentlich – im Dezember 2025) als eine Form des Schreibens herausgestellt, die mir offenbar Spaß macht (und zudem Leser und Leserinnen findet).…

Wer diesen Blog regelmäßig liest, kennt mich als einen engagierten Freund des Grundgesetzes (GG). Mich hat es als einem nur geringfügig Jüngeren ein Leben lang begleitet – und was soll ich sagen: ich bin nach wie vor begeistert! Was sich die Väter und Mütter des Grundgesetzes 1949 ausgedacht haben, standen natürlich unter dem Eindruck der Erfahrungen der Nazizeit.…

Beim Umzug von meinem alten (großen) Büro A028 ins neue (kleinere) Büro A010 habe ich viele Akten weggeworfen (ich weiß, ich werde es bereuen). Ein voller Ordner hat überlebt: Er trägt den Titel „Abgelehnte Anträge“ und enthält eine Reihe von Forschunganträgen, von denen ich zum Zeitpunkt der Antragstellung sehr überzeugt war, aber die Gutachter sich meine Meinung nicht zu eigen machen konnten.…

Gastbeitrag von Bernd Reuschenbach, KSH München:

Im Sommer 2023 wollte ich im Rahmen der Feierlichkeiten zum 70. Geburtstag von Joachim Funke etwas zur Auswertung des Heipi-Blogs sagen, aber die Rednerliste war lang und die Analysen noch nicht weit fortgeschritten.

Erste Einblicke in die Auswertung der HeiPi-Blog-Beiträge und damit Anregungen für die genauere Analyse gebe ich hiermit gerne.

Der erste Beitrag im HeiPi-Blog wurde am 7.…

Am 22. April 2024 jährt sich zum 300. Mal der Geburtstag von Immanuel Kant (22.4.1724 bis 12.2.1804). Auch wenn seine Meinung zur Psychologie nicht besonders viel hergibt, hat er doch mit seiner Philosophie sehr viel zum Zeitalter der Aufklärung beigetragen. Gemessen an den von Kant aufgestellten Kriterien für Wissenschaftlichkeit kann eine naturwissenschaftlich ausgerichtete Psychologie nur einen unteren Rang beanspruchen (siehe hier).…

Norbert Groeben feiert am 19.4.2024 seinen 80. Geburtstag – als jemand, der den Heidelberger „Groeben-Lehrstuhl“ übernommen hat, steht mir vielleicht eine Gratulation zu.

Sein akademischer Werdegang (in aller Kürze – ich zitiere aus seinem Wikipedia-Eintrag): „Norbert Groeben studierte ab 1963 Psychologie, Germanistik, Philosophie, katholische Theologie und Soziologie an den Universitäten Mainz, Wien und Münster.…

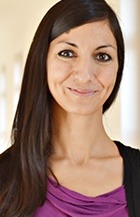

Seit 1. April 2024 verstärkt Katajun Lindenberg unser Team am Psychologischen Institut: Sie ist ab sofort als Professorin für Kinder- und Jugendlichenpsychotherapie bei uns beschäftigt.

Katajun Lindenberg, die ich noch als Studentin kennengelernt habe (Abschluss 2007), hat eine Reihe von Stationen an verschiedenen Orten durchlaufen: Promoviert wurde sie 2012 an der Universität Heidelberg mit einer Wirksamkeitsstudie über ein onlinebasiertes Programm zur Prävention von Essstörungen; dann Klinik für Kinder- und Jugendpsychiatrie sowie Institut für Familientherapie am Universitätsklinikum Heidelberg; ab 2013 an der Pädagogischen Hochschule Heidelberg als Juniorprofessorin für Entwicklungspsychologie; seit April 2020 als Professorin für Kinder- und Jugendlichenpsychotherapie an der Goethe-Universität Frankfurt.…

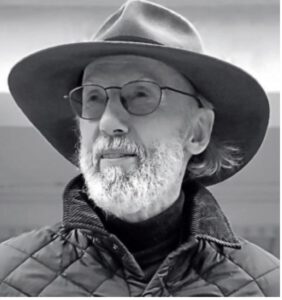

Am 29.3.2024 wird Jürgen Bredenkamp 85 Jahre alt. Für mich, der ich 15 wichtige Jahre (von 1982-1997) in seiner Abteilung (zunächst 1982-1984 in Trier, später in Bonn 1984-1997) tätig war, ein Anlass zur Rückschau und zum Dank.

(Foto: JF)

Ein paar Worte zunächst zu seinem Lebenslauf, die ich aus seinem Wikipedia-Eintrag zitiere: „Er studierte von 1958 an zunächst Jura, dann Psychologie, Physiologie und Philosophie.…

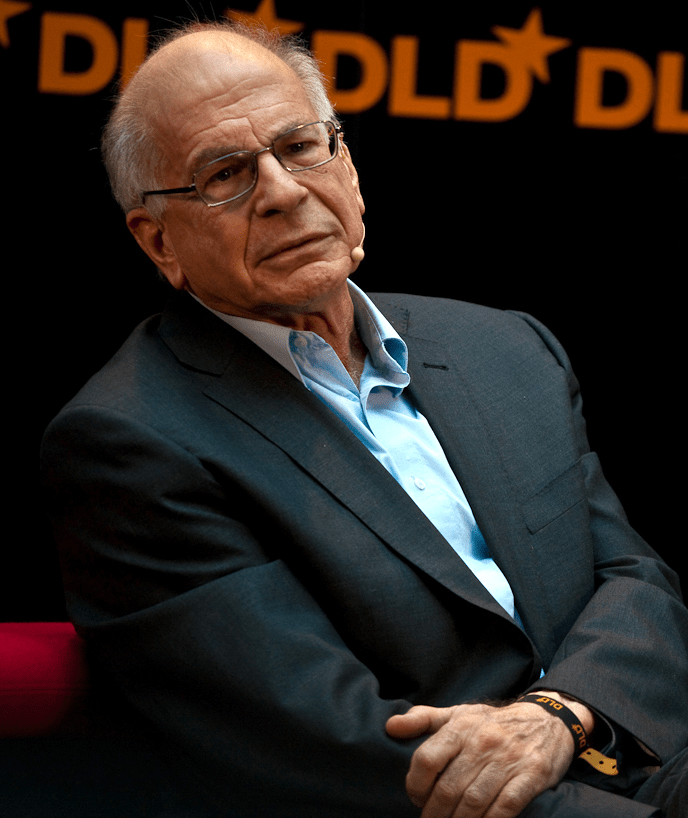

Ich zitiere -leicht geändert/ergänzt- aus The Pioneer Briefing von Gabor Steingart:

Der weltbekannte Psychologe „Daniel Kahneman ist gestern (27.3.2024) im Alter von 90 Jahren gestorben. Der 1934 in Tel Aviv geborene israelisch-amerikanische Psychologe und Verhaltensökonom galt als Popstar der Wirtschaftswissenschaften.…

In der Zeitung lese ich, dass die Simpsons nun seit 35 Jahren ihr Unwesen treiben. Ich bin bekennender Fan der Simpsons und kann über viele Episoden herzlich lachen! Manches ist so unkorrekt wie nur eben möglich. Dass das Ganze auf dem (rechtslastigen und Trump-freundlichen) Sender Fox läuft, ist erstaunlich: Viele Scherze richten sich gegen Donald Trump und seine konservativen Aussagen. …